Introdução ao Procore Analytics 2.0

Índice

- Procore Analytics Conector de nuvem

- Iniciar a instalação

- Escolher um método de conexão de dados

- Conectar-se à área de trabalho de BI de alimentação

- Conectar-se ao SQL Server usando Python (SSIS)

- Conectar-se ao SQL Server usando a biblioteca Python

- Conectar-se ao SQL Server usando o Python Spark

- Conectar-se ao ADLS usando o Azure Functions

- Conectar-se ao ADLS usando Python

- Conectar-se ao ADLS usando o Spark

- Conectar-se ao Fabric Lakehouse usando o Data Factory

- Conecte-se ao Fabric Lakehouse usando blocos de anotações de tecido

- Conectar-se ao SQL Server usando o Azure Functions

- Conectar-se ao SQL Server usando o Data Factory

- Conectar-se ao SQL Server usando o Bloco de Anotações de Malha

- Conectar-se a databricks

- Conectar-se ao Snowflake usando Python

- Conectar-se ao Amazon S3 usando Python

- Crie sua própria conexão

Procore Analytics Conector de nuvem

Introdução

O Cloud Connector é como o Procore compartilha dados, inteligência e análises com nossos clientes. Isso pode ser compartilhado diretamente com ferramentas de relatório, como Power BI ou Tableau. Ele também pode ser compartilhado com data warehouses, lojas, lagos ou outros aplicativos dos clientes. Os clientes podem até mesmo criar acesso programático aos seus dados usando o Cloud Connector para uma verdadeira automação. O Cloud Connector é baseado no protocolo de compartilhamento aberto Delta Share.

Opções de conector de dados guiados do Procore Analytics 2.0

O Delta Sharing é o primeiro protocolo aberto do setor para compartilhamento seguro de dados, facilitando o compartilhamento de dados com outras organizações, independentemente das plataformas de computação usadas. Muitos aplicativos podem acessar dados com o Delta Share. No entanto, para aprimorar ainda mais a experiência do cliente, o Procore adicionou conectores, código pré-criado e guias para as seguintes plataformas, reduzindo o tempo de configuração e a complexidade para permitir uma conexão perfeita e pronta para uso.

- SQL Server

- SSIS Python

- Biblioteca Python

- Centelha Python

- Azul

- ADLS Azure Functions

- ADLS Python

- Faísca ADLS

- Lakehouse Fabric Data Factory

- Notebook de tecido Lakehouse

- SQL Server Azure Functions

- Fábrica de dados do SQL Server Fabric

- Bloco de anotações do SQL Server Fabric

- Tijolos de dados

- Floco de neve

- Amazon S3

- Guias para escrever o seu próprio (GitHub)

Mais conectores de dados em breve!

Acesse a documentação e o código

Documentação abrangente e exemplos de código estão disponíveis no produto Procore Analytics diretamente no aplicativo Web do Procore, acessível por seus administradores do Procore. Esses recursos fornecem instruções passo a passo, trechos de código e práticas recomendadas para ajudá-lo a configurar e gerenciar sua integração de dados de forma eficaz.

Próximos passos

Continue para a próxima seção deste guia para iniciar o processo de configuração.

Para consultas ou assistência adicionais, entre em contato com seu gerente de conta ou nossa equipe de suporte.

Verificar permissões

Obs.

- Você precisa ter a ferramenta Analytics habilitada no nível de empresa para a conta Procore da sua empresa.

- Qualquer pessoa com acesso de nível "Administrador" à ferramenta do Google Analytics pode conceder acesso à ferramenta do Google Analytics a usuários adicionais.

- Para gerar um token de acesso, os usuários precisam ter acesso de nível "Administrador" à ferramenta Analytics.

- Qualquer alteração nas permissões de um usuário no Diretório do Google Analytics levará até 24 horas para ficar ativa.

Certifique-se de que as permissões adequadas sejam atribuídas para gerar um token de acesso para que possa começar a conectar seus dados do Procore à sua solução de BI. O acesso ao Google Analytics está vinculado ao seu login credenciais do Procore, que permite gerar um único token de acesso. O token de acesso é uma sequência de dígitos que você inserirá em seu sistema de BI para acessar os dados.

Normalmente, os usuários que precisam de tokens de acesso são engenheiros de dados ou desenvolvedores do Power BI. Se você tiver acesso ao Google Analytics em várias empresas, seu token permitirá que você extraia dados de todas elas. O token está vinculado a você, não a uma empresa específica, portanto, permanece o mesmo em todas as empresas às quais você tem acesso.

Os administradores da empresa e do projeto receberão uma função de administrador por padrão. Os seguintes níveis de acesso de usuário são permitidos para a ferramenta do Google Analytics:

- Nenhum: Sem acesso aos dados do Google Analytics.

- Administrador: tem permissões de acesso total aos dados de todas as ferramentas e projetos (exceto determinados dados marcados como privados, como dados de correspondência).

Há duas maneiras de atribuir permissões a usuários individuais:

Revogando o acesso

O acesso aos dados na ferramenta do Google Analytics será revogado quando as permissões de um usuário para a ferramenta forem removidas. Além disso, se o registro de contato de um usuário ficar inativo, ele também perderá o acesso aos dados do Google Analytics.

Gerar credenciais de acesso a dados

Para começar a acessar seus dados do Procore, há duas opções para gerar seus credenciais de acesso aos dados: o método de conexão direta do Databricks ou o método Delta Share Token. O token de acesso é uma cadeia de dígitos que você inserirá no conector de dados aplicável para acessar os dados.

Considerações

- É necessário ter a ferramenta Procore Analytics habilitada.

- Por padrão, todos os administradores da empresa têm acesso de nível "Administrador" ao Google Analytics no Diretório.

- Qualquer pessoa com acesso de nível "Administrador" ao Google Analytics pode conceder acesso à ferramenta do Google Analytics a usuários adicionais.

- Para gerar um token de dados, os usuários precisam ter acesso de nível "Administrador" à ferramenta Analytics.

Passos

- Faça login no Procore.

- Clique no ícone Conta & Perfil na área superior direita da barra de navegação.

- Clique em Configurações do meu perfil.

- Em Escolher sua conexão com Procore Analytics, você tem duas opções para gerar credenciais:

- Os Databricks se conectam diretamente OU geram um token de acesso pessoal com o Delta Share.

- Insira seu Identificador de Compartilhamento do Databricks para o método de conexão direta do Databricks e clique em Conectar. Consulte Conectar seus dados do Procore a um espaço de trabalho do Databricks para saber mais.

- Para o método de token, selecione Delta Share Token.

- Certifique-se de escolher um data de vencimento.

- Clique em Gerar tokens.

Importante! É recomendável que você copie e armazene seu token para referência futura, pois o Procore não armazena tokens para usuários. - Você usará seu Token de Portador, Nome do Compartilhamento, URL do servidor de compartilhamento Delta e sua Versão de Credenciais de Compartilhamento para começar a acessar e integrar seus dados.

- Explore as seções adicionais do Guia de Introdução para ver as próximas etapas sobre como conectar seus dados com base no método de conexão de dados desejado.

Obs.

- O token desaparecerá após uma hora ou também desaparecerá se você sair da página. Para gerar um novo token, retorne à Etapa 1.

- Pode levar até 24 horas para que os dados fiquem visíveis.

- Por favor, não regenere seu token durante esse tempo de processamento, pois isso pode causar problemas com seu token.

Carregar relatórios no Power BI (se aplicável)

- Acesse Procore Analytics no menu Ferramentas da empresa.

- Vá para a seção Introdução .

- Em Arquivos do Power BI, selecione e baixe os relatórios do Power BI disponíveis.

- Faça logon no serviço do Power BI usando seu login credenciais do Power BI.

- Crie um espaço de trabalho onde você deseja armazenar os relatórios de Procore Analytics da sua empresa. Consulte a documentação de suporte do Power BI da Microsoft para obter mais informações.

Anotações: Requisitos de licenciamento podem ser aplicados. - No espaço de trabalho, clique em Fazer upload.

- Agora clique em Procurar.

- Selecione o arquivo de relatório do seu local em seu computador e clique em Abrir.

- Após o upload do arquivo, clique em Filtrar e selecione Modelo semântico.

- Passe o cursor sobre a linha com o nome do relatório e clique no ícone de reticências

verticais.

verticais. - Clique em Definições.

- Na página de definições, clique em Credenciais de origem de dados e clique em Editar credenciais.

- Na janela "Configurar [nome do relatório]" exibida, faça o seguinte:

- Método de autenticação: Selecione "Chave".

- Chave da conta: insira o token que você recebeu da página de geração de tokens no Procore.

- Definição de nível de privacidade para essa fonte de dados: selecione o nível de privacidade. Recomendamos selecionar "Privado" ou "Organizacional". Ver Documentação compatível com Power BI da Microsoft para obter mais informações sobre os níveis de privacidade.

- Clique em Entrar.

- Clique em Refresh e faça o seguinte:

- Fuso horário: selecione o fuso horário que deseja usar para atualizações de dados programados.

- Em Configurar uma agenda de atualização, alterne o seletor para a posição ATIVADO.

- Atualize a ação: selecione "RDO".

- Horário: clique em Adicionar outro horário e selecione 7:00 a.m.

Nota: Você pode adicionar até 8 vezes de atualização. - Opcional:

- Marque a caixa de verificação "Enviar notificações de falha de atualização ao proprietário do conjunto de dados" para enviar notificações de falha de atualização.

- Digite os endereços de e-mail de qualquer outro colega para o qual deseja que o sistema envie notificações de falha de atualização.

- Clique em Aplicar.

- Para verificar se as definições foram configuradas corretamente e que os dados do relatório serão atualizados corretamente, retorne à página "Filtrar e selecione Modelo semântico" e conclua as seguintes etapas:

- Passe o cursor sobre a linha com o nome do relatório e clique no ícone de seta circular para atualizar os dados manualmente.

- Verifique a coluna "Atualizado" para ver se há um ícone de aviso

.

.

- Se nenhum ícone de aviso for exibido, os dados do relatório serão atualizados com êxito.

- Se um ícone de aviso for exibido, ocorreu um erro. Clique no ícone de aviso

para ver mais informações sobre o erro.

para ver mais informações sobre o erro.

- Para excluir o painel em branco que o serviço de Power BI criou automaticamente, execute as seguintes etapas:

- Passe o cursor sobre a linha com o nome do painel. Clique no ícone de reticências

e clique em Excluir.

e clique em Excluir.

- Passe o cursor sobre a linha com o nome do painel. Clique no ícone de reticências

- Para verificar se o relatório é renderizado corretamente, acesse a página "Tudo" ou "Conteúdo" e clique no nome do relatório para visualizar o relatório no serviço Power BI.

Ponta

Consulte a coluna "Tipo" para garantir que você clique no relatório em vez de um ativo diferente.

- Repita as etapas acima no Power BI para cada arquivo de relatório Procore Analytics.

Conectar-se à área de trabalho de BI de alimentação

Obs.

Esses métodos de conexão são normalmente usados por profissionais de dados.Conectar novos dados

- Abra sua área de trabalho com bi de energia.

- Clique em Obter dados e selecione Mais.

- Na barra de pesquisa, digite "Compartilhamento Delta".

- Selecione Delta Sharing e clique em Conectar.

- Digite ou cole o URL do Servidor de Compartilhamento Delta que você recebeu do Procore.

- Clique em OK.

- Se esta for a primeira vez que você se conectar a essa fonte, você será solicitado a fornecer seu Token de bearer de compartilhamento Delta.

- Clique em Conectar.

- Após a autenticação, selecione as Procore Analytics tabelas que deseja inserir em seu relatório de BI do poder.

- Selecione Carregar para visualizar seu relatório ou selecione Transformar dados para fazer mais transformaçãos na Consulta de energia.

Conectar-se a um modelo existente

- Abra o Power BI Desktop.

- Clique no menu suspenso Transformar dados e selecione Configurações da fonte de dados .

- Selecione Editar permissões.

- Clique em Editar.

- Insira o token que você recebeu do Google Analytics 2.0.

- Clique em Atualizar.

- Agora, as colunas personalizadas do orçamento aparecerão nas tabelas Budget e BudgetSnapshots.

Conectar-se ao SQL Server usando Python (SSIS)

Visão geral

A ferramenta Procore Analytics Cloud Connect Access é uma interface de linha de comando (CLI) que ajuda a configurar e gerenciar transferências de dados do Procore para o MS SQL Server. Consiste em dois componentes principais:

- user_exp.py (Utilitário configuração configuração)

- delta_share_to_azure_panda.py (script de sincronização de dados)

Pré-requisitos

- Python e pip instalados em seu sistema.

- Acesso ao Procore Delta Share.

- Conta do MS SQL Server credenciais.

- Instale as dependências necessárias: pip install -r requirements.txt.

Passos

- Configuração Inicial

- Sincronização de dados

- Configuração de compartilhamento delta

- Configuração do MS SQL Server

- Configuração do SSIS

Configuração Inicial

- Execute o utilitário de configuração:

user_exp.py Python

Isso ajudará você a configurar o seguinte:

- Configuração de origem do compartilhamento delta

- Configuração de destino do MS SQL Server

- Preferências de agendamento

Sincronização de dados

Após a configuração, você tem duas opções para executar a sincronização de dados:

- python de execução direta

delta_share_to_azure_panda.py

OU - Execução Programada

Se configurado durante configuração, o trabalho será executado automaticamente de acordo com sua programação cron.

Configuração de compartilhamento delta

- Crie um novo arquivo chamado config.share com seu Delta Share credenciais no formato JSON.

{

"shareCredentialsVersion": 1,

"bearerToken": "xxxxxxxxxxxxx",

"ponto de extremidade": "https://nvirginia.nuvem. databricks.c... alojas/xxxxxx"

}

- Obtenha os campos obrigatórios:

Nota: Esses detalhes podem ser obtidos no aplicativo Web Procore Analytics.- ShareCredentialsVersion: Número da versão (atualmente 1).

- BearerToken: Seu token de acesso Delta Share.

- Ponto de extremidade: seu endpoint de compartilhamento Delta URL.

- Salve o arquivo em um local seguro.

- Ao configurar a fonte de dados, você será solicitado a fornecer:

- Lista de tabelas (separadas por vírgula).

- Deixe em branco para sincronizar todas as tabelas.

- Exemplo: 'table1, t able2, table3'.

- Caminho para o seu 'config.share' arquivo.

Configuração do MS SQL Server

Você precisará fornecer os seguintes detalhes do MS SQL Server:

- base de dados

- anfitrião

- senha

- esquema

- nome de usuário

Configuração do SSIS

- Usando a linha de comando, navegue até a pasta <path to the folder> digitando'cd'.

- Instale os pacotes necessários usando 'pip install -r requirements.txt' ou 'python -m pip install -r requirements.txt'.

- Abra o SSIS e crie um novo projeto.

- Na Caixa de Ferramentas do SSIS, arrastar e soltar atividade "Executar tarefa de processo".

- Clique duas vezes em 'Executar tarefa do processo' e navegue até a guia Processo.

- Em 'Executável', digite o caminho para python.exe na pasta de instalação do python.

- Em 'WorkingDirectory', insira um caminho para a pasta que contém o script que você deseja executar (sem o nome do arquivo de script).

- Em 'Argumentos', digite o nome do script 'delta_share_to_azure_panda.py' você deseja executar com o .py extensão e salvar.

- Clique no botão 'Iniciar' no painel superior:

- Durante a execução da tarefa, a saída do console Python é exibida na janela do console externo.

- Quando a tarefa estiver concluída, ele exibirá um tick verde:

Conectar-se ao SQL Server usando a biblioteca Python

Visão geral

Este guia fornece instruções detalhadas para configurar e usar o pacote de integração do Compartilhamento Delta em um sistema operacional Windows para integrar dados perfeitamente em seus fluxos de trabalho com Procore Analytics. O pacote suporta várias opções de execução, permitindo que você escolha a configuração e o método de integração desejados.

Pré-requisitos

Certifique-se de ter o seguinte antes de prosseguir:

- Procore Analytics 2.0 SKU

- Arquivo pofile de compartilhamento delta:

Obtenha seu arquivo *.share contendo o Delta Sharing credenciais. Por conveniência, copie-o para o diretório do pacote. - Ambiente Python: Instale o Python 3 e o pip em seu sistema.

- Faça o download do Python.

- Como alternativa, use a Microsoft Store.

Passos

- Preparar o Pacote

- Instalar dependências

- Gerar configuração

- Configurar Cron Jobs e Execução Imediata

- Execução e Manutenção

Preparar o Pacote

- Crie um novo arquivo chamado config.share com seu Delta Share credenciais no formato JSON.

{

"shareCredentialsVersion": 1,

"bearerToken": "xxxxxxxxxxxxx",

"ponto de extremidade": "https://nvirginia.nuvem. databricks.c... alojas/xxxxxx"

}

- Obtenha os campos obrigatórios.

Nota: Esses detalhes podem ser obtidos no aplicativo Web Procore Analytics.- ShareCredentialsVersion: Número da versão (atualmente 1).

- BearerToken: Seu token de acesso Delta Share.

- Ponto de extremidade: seu endpoint de compartilhamento Delta URL.

- Baixe e extraia o pacote.

- Descompacte o pacote em um diretório de sua escolha.

- Copie o arquivo de perfil *.share Delta Sharing para o diretório do pacote para facilitar o acesso.

Instalar dependências

- Abra um terminal no diretório do pacote.

- Execute o seguinte comando para instalar as dependências:

- pip install -r requirements.txt

Gerar configuração

- Gere o arquivo config.yaml executando python user_exp.py:

Esse script ajuda a gerar o arquivo config.yaml que contém credenciais e configurações necessárias. - Ao configurar a fonte de dados, você será solicitado a fornecer:

- Lista de tabelas (separadas por vírgula).

- Deixe em branco para sincronizar todas as tabelas.

Exemplo: 'tabela1, tabela2, tabela3'. - Caminho para o seu 'config.share' arquivo.

- Pela primeira vez, você fornecerá seus credenciais como local de configuração de origem do Delta Share, tabelas, banco de dados, host e etc.

Nota: Depois, você pode reutilizar ou atualizar a configuração manualmente ou pelo user_exp.py python em execução novamente.

Configurar trabalhos cron e execução imediata (opcional)

- Decida se deseja configurar um trabalho cron para execução automática.

- Forneça um cronograma cron:

- Formato: * * * * * ( minuto, hora, dia-do-mês, mês, dia-da-semana).

- Exemplo para execução diária às 2 da manhã: 0 2 * * *

- Para verificar os registros de agendamento, o arquivo 'procore_scheduling.log' será criado assim que o agendamento for configurado.

Você também pode verificar o agendamento executando o comando no terminal:

Para Linux e MacOs:

Para editar/excluir - edite o cron de agendamento usando:

''Bash

EDITOR=nano crontab -e

```

- Depois de executar o comando acima, você verá algo semelhante a:

- 2 * * * * /Users/your_user/snowflake/venv/bin/python /Users/your_user/snowflake/sql_server_python/connection_config.py 2>&1 | durante a linha de leitura; fazer echo "$(date) - $line"; feito >> /Users/your_user/snowflake/sql_server_python/procore_scheduling.log #procore-data-import

- Você também pode ajustar o cron do cronograma ou excluir toda a linha para interrompê-lo em execução por agendamento.

Para Windows:

- Verifique se a tarefa do cronograma foi criada:

'''powershell

schtasks /query /tn "ProcoreDeltaShareScheduling" /fo LIST /v

``` - Para editar/excluir - agendando tarefa:

Abra o Agendador de Tarefas:- Pressione Win + R, digite taskschd.msc, e pressione Enter.

- Navegue até as tarefas agendadas.

- No painel esquerdo, expanda a Biblioteca do Agendador de Tarefas.

- Procure a pasta onde sua tarefa foi salva (por exemplo, Biblioteca do Agendador de Tarefas ou uma pasta personalizada).

- Encontre sua tarefa:

- Procure o nome da tarefa ProcoreDeltaShareScheduling.

- Clique nele para visualizar seus detalhes no painel inferior.

- Confira sua programação:

- Verifique a guia Gatilhos para ver quando a tarefa está definida para ser executada.

- Verifique a guia Histórico para confirmar as execuções recentes.

- Para excluir tarefa:

- Exclua a tarefa da GUI.

Questão de Execução Imediata:

- Opção para executar script para copiar dados imediatamente após a configuração.

- Depois de gerar o config.yaml, a CLI está pronta para ser executada a qualquer momento de forma independente, executando script para copiar dados, dependendo do seu pacote. Veja exemplos abaixo:

delta_share_to_azure_panda.py Python

OU

Python delta_share_to_sql_spark.py

OU

Python delta_share_to_azure_dfs_spark.py

Execução e Manutenção

Problemas e soluções comuns

- Configuração do trabalho Cron:

- Verifique se as permissões do sistema estão configuradas corretamente.

- Verifique os logs do sistema se o trabalho não for executado.

- Verifique se o script delta_share_to_azure_panda.py tem permissões de execução.

- Arquivo de configuração:

- Verifique se o arquivo config.yaml está no mesmo diretório que o script.

- Faça backup do arquivo antes de fazer alterações.

Suporte

Para obter ajuda adicional:

- Revise os logs de script para obter mensagens de erro detalhadas.

- Verifique se há configurações incorretas no arquivo config.yaml .

- Entre em contato com o administrador do sistema para problemas relacionados à permissão.

- Entre em contato com suporte do Procore para problemas relacionados ao acesso ao Delta Share.

- Revise o log de tabelas com falha: failed_tables.log.

Obs.

- Sempre faça backup de seus arquivos de configuração antes de fazer alterações.

- Teste novas configurações em um ambiente que não seja de produção para evitar interrupções.

Conectar-se ao SQL Server usando o Python Spark

Visão geral

Este guia fornece instruções detalhadas para configurar e usar o pacote de integração do Compartilhamento Delta em um sistema operacional Windows para integrar dados perfeitamente em seus fluxos de trabalho com Procore Analytics. O pacote suporta várias opções de execução, permitindo que você escolha a configuração e o método de integração desejados.

Pré-requisitos

Certifique-se de ter o seguinte antes de prosseguir:

- Procore Analytics 2.0 SKU

- Arquivo pofile de compartilhamento delta:

Obtenha seu arquivo *.share contendo o Delta Sharing credenciais. Por conveniência, copie-o para o diretório do pacote. - Ambiente Python: Instale o Python 3 e o pip em seu sistema.

- Faça o download do Python.

- Como alternativa, use a Microsoft Store.

Passos

- Preparar o Pacote

- Instalar dependências

- Gerar configuração

- Configurar Cron Jobs e Execução Imediata

- Execução e Manutenção

Preparar o Pacote

- Crie um novo arquivo chamado config.share com seu Delta Share credenciais no formato JSON.

{

"shareCredentialsVersion": 1,

"bearerToken": "xxxxxxxxxxxxx",

"ponto de extremidade": "https://nvirginia.nuvem. databricks.c... alojas/xxxxxx"

}

- Obtenha os campos obrigatórios.

Nota: Esses detalhes podem ser obtidos no aplicativo Web Procore Analytics.- ShareCredentialsVersion: Número da versão (atualmente 1).

- BearerToken: Seu token de acesso Delta Share.

- Ponto de extremidade: seu endpoint de compartilhamento Delta URL.

- Baixe e extraia o pacote.

- Descompacte o pacote em um diretório de sua escolha.

- Copie o arquivo de perfil *.share Delta Sharing para o diretório do pacote para facilitar o acesso.

Instalar dependências

- Abra um terminal no diretório do pacote.

- Execute o seguinte comando para instalar as dependências:

- pip install -r requirements.txt

Gerar configuração

- Gere o arquivo config.yaml executando python user_exp.py:

Esse script ajuda a gerar o arquivo config.yaml que contém credenciais e configurações necessárias. - Ao configurar a fonte de dados, você será solicitado a fornecer:

- Lista de tabelas (separadas por vírgula).

- Deixe em branco para sincronizar todas as tabelas.

Exemplo: 'tabela1, tabela2, tabela3'. - Caminho para o seu 'config.share' arquivo.

- Pela primeira vez, você fornecerá seus credenciais como local de configuração de origem do Delta Share, tabelas, banco de dados, host e etc.

Nota: Depois, você pode reutilizar ou atualizar a configuração manualmente ou pelo user_exp.py python em execução novamente.

Configurar trabalhos cron e execução imediata (opcional)

- Decida se deseja configurar um trabalho cron para execução automática.

- Forneça um cronograma cron:

- Formato: * * * * * ( minuto, hora, dia-do-mês, mês, dia-da-semana).

- Exemplo para execução diária às 2 da manhã: 0 2 * * *

- Para verificar os registros de agendamento, o arquivo 'procore_scheduling.log' será criado assim que o agendamento for configurado.

Você também pode verificar o agendamento executando o comando no terminal:

Para Linux e MacOs:

Para editar/excluir - edite o cron de agendamento usando:

''Bash

EDITOR=nano crontab -e

```

- Depois de executar o comando acima, você verá algo semelhante a:

- 2 * * * * /Users/your_user/snowflake/venv/bin/python /Users/your_user/snowflake/sql_server_python/connection_config.py 2>&1 | durante a linha de leitura; fazer echo "$(date) - $line"; feito >> /Users/your_user/snowflake/sql_server_python/procore_scheduling.log #procore-data-import

- Você também pode ajustar o cron do cronograma ou excluir toda a linha para interrompê-lo em execução por agendamento.

Para Windows:

- Verifique se a tarefa do cronograma foi criada:

'''powershell

schtasks /query /tn "ProcoreDeltaShareScheduling" /fo LIST /v

``` - Para editar/excluir - agendando tarefa:

Abra o Agendador de Tarefas:- Pressione Win + R, digite taskschd.msc, e pressione Enter.

- Navegue até as tarefas agendadas.

- No painel esquerdo, expanda a Biblioteca do Agendador de Tarefas.

- Procure a pasta onde sua tarefa foi salva (por exemplo, Biblioteca do Agendador de Tarefas ou uma pasta personalizada).

- Encontre sua tarefa:

- Procure o nome da tarefa ProcoreDeltaShareScheduling.

- Clique nele para visualizar seus detalhes no painel inferior.

- Confira sua programação:

- Verifique a guia Gatilhos para ver quando a tarefa está definida para ser executada.

- Verifique a guia Histórico para confirmar as execuções recentes.

- Para excluir tarefa:

- Exclua a tarefa da GUI.

Questão de Execução Imediata:

- Opção para executar script para copiar dados imediatamente após a configuração.

- Depois de gerar o config.yaml, a CLI está pronta para ser executada a qualquer momento de forma independente, executando script para copiar dados, dependendo do seu pacote. Veja exemplos abaixo:

delta_share_to_azure_panda.py Python

OU

Python delta_share_to_sql_spark.py

OU

Python delta_share_to_azure_dfs_spark.py

Execução e Manutenção

Problemas e soluções comuns

- Configuração do trabalho Cron:

- Verifique se as permissões do sistema estão configuradas corretamente.

- Verifique os logs do sistema se o trabalho não for executado.

- Verifique se o script delta_share_to_azure_panda.py tem permissões de execução.

- Arquivo de configuração:

- Verifique se o arquivo config.yaml está no mesmo diretório que o script.

- Faça backup do arquivo antes de fazer alterações.

Suporte

Para obter ajuda adicional:

- Revise os logs de script para obter mensagens de erro detalhadas.

- Verifique se há configurações incorretas no arquivo config.yaml .

- Entre em contato com o administrador do sistema para problemas relacionados à permissão.

- Entre em contato com o suporte do Procore para problemas relacionados ao acesso ao Delta Share.

- Revise o log de tabelas com falha: failed_tables.log.

Obs.

- Sempre faça backup de seus arquivos de configuração antes de fazer alterações.

- Teste novas configurações em um ambiente que não seja de produção para evitar interrupções.

Conectar-se ao ADLS usando o Azure Functions

Visão geral

Este guia orienta você na configuração e implantação de uma Função do Azure para integrar dados de Compartilhamento Delta com Procore Analytics. A Função do Azure permite fluxos de trabalho eficientes de processamento e compartilhamento de dados com perfis de Compartilhamento Delta.

Pré-requisitos

- Procore Analytics SKU 2.0.

- Arquivo de perfil de compartilhamento Delta:

- Seu arquivo *.share contendo o Delta Sharing credenciais. Por conveniência, coloque-o dentro do pacote baixado.

- Ambiente Python:

- Instalado Python 3.9+ e pip em seu sistema.

- Instalação do Azure:

- CLI do Azure instalada e conectada.

- O Azure Functions ferramentas principais instalado.

Passos

- Prepare the Package

- Install Dependencies

- Generate Configuration

- Azure CLI Setup

- Install Azure Functions Core Tools

- Prepare the Azure Function

- Deployment

- Validation

Preparar o Pacote

- Faça o download do pacote necessário (adls_azure_function ou sql_server_azure_function).

- Extraia os arquivos de pacote para um diretório local.

- Coloque o arquivo de compartilhamento Delta:

- Copie seu arquivo de perfil *.share Delta Sharing para o diretório extraído.

Instalar dependências

- Abra um terminal no diretório do pacote.

- Execute o seguinte comando para instalar as dependências necessárias do Python:

- pip install -r requirements.txt

Gerar configuração

- Gere o arquivo config.yaml executando:

- user_exp.py Python

- O script solicitará que você insira credenciais como:

- Tabelas

- Nome do banco de dados

- Anfitrião

- credenciais adicionais.

- A configuração pode ser reutilizada ou atualizada manualmente ou executando novamente o user_exp.py python.

Configuração da CLI do Azure

- Faça logon no Azure.

- Execute o seguinte comando para fazer login:

az login - Verifique a conta do Azure:

- az account show

- Se o comando az não estiver disponível, instale a CLI do Azure seguindo as instruções encontradas aqui: Microsoft Learn.

Instalar o Azure Functions ferramentas principais

Ir para

para obter instruções sobre como instalar o Azure Functions ferramentas principais.Preparar a função do Azure

- Use o botãoPara criar o seguinte:

- Um aplicativo de função

- Um grupo de recursos

- Plano de consumo

- Conta de armazenamento

- Definir agendamento Cron personalizado (opcional).

- Abra function_app.py em um editor.

- Localize a linha: @app.timer_trigger(schedule="0 0 */8 * * *",

- Substitua o agendamento por sua expressão Cron personalizada e salve o arquivo.

Implantação

- Abra um terminal no diretório de pacotes (adls_azure_function).

- Execute o seguinte comando de implantação:

- func azure functionapp publish <FunctionAppName> --build remote --python --clean

- Substitua<FunctionAppName> pelo nome do seu aplicativo de função do Azure em sua assinatura do Azure.

Validação

- Certifique-se de que a implantação seja bem-sucedida verificando o status do aplicativo de função no Portal do Azure.

- Monitore os logs para verificar se a função está sendo executada conforme o esperado.

Conectar-se ao ADLS usando Python

Visão geral

Este guia fornece instruções detalhadas para configurar e usar o pacote de integração do Compartilhamento Delta em um sistema operacional Windows para integrar dados perfeitamente em seus fluxos de trabalho com Procore Analytics. O pacote suporta várias opções de execução, permitindo que você escolha a configuração e o método de integração desejados.

Pré-requisitos

Certifique-se de ter o seguinte antes de prosseguir:

- Procore Analytics 2.0 SKU

- Arquivo pofile de compartilhamento delta:

Obtenha seu arquivo *.share contendo o Delta Sharing credenciais. Por conveniência, copie-o para o diretório do pacote. - Ambiente Python: Instale o Python 3 e o pip em seu sistema.

- Faça o download do Python.

- Como alternativa, use a Microsoft Store.

Passos

- Preparar o Pacote

- Instalar dependências

- Gerar configuração

- Configurar Cron Jobs e Execução Imediata

- Execução e Manutenção

Preparar o Pacote

- Crie um novo arquivo chamado config.share com seu Delta Share credenciais no formato JSON.

{

"shareCredentialsVersion": 1,

"bearerToken": "xxxxxxxxxxxxx",

"ponto de extremidade": "https://nvirginia.nuvem. databricks.c... alojas/xxxxxx"

}

- Obtenha os campos obrigatórios.

Nota: Esses detalhes podem ser obtidos no aplicativo Web Procore Analytics.- ShareCredentialsVersion: Número da versão (atualmente 1).

- BearerToken: Seu token de acesso Delta Share.

- Ponto de extremidade: seu endpoint de compartilhamento Delta URL.

- Baixe e extraia o pacote.

- Descompacte o pacote em um diretório de sua escolha.

- Copie o arquivo de perfil *.share Delta Sharing para o diretório do pacote para facilitar o acesso.

Instalar dependências

- Abra um terminal no diretório do pacote.

- Execute o seguinte comando para instalar as dependências:

- pip install -r requirements.txt

Gerar configuração

- Gere o arquivo config.yaml executando python user_exp.py:

Esse script ajuda a gerar o arquivo config.yaml que contém credenciais e configurações necessárias. - Ao configurar a fonte de dados, você será solicitado a fornecer:

- Lista de tabelas (separadas por vírgula).

- Deixe em branco para sincronizar todas as tabelas.

Exemplo: 'tabela1, tabela2, tabela3'. - Caminho para o seu 'config.share' arquivo.

- Pela primeira vez, você fornecerá seus credenciais como local de configuração de origem do Delta Share, tabelas, banco de dados, host e etc.

Nota: Depois, você pode reutilizar ou atualizar a configuração manualmente ou pelo user_exp.py python em execução novamente.

Configurar trabalhos cron e execução imediata (opcional)

- Decida se deseja configurar um trabalho cron para execução automática.

- Forneça um cronograma cron:

- Formato: * * * * * ( minuto, hora, dia-do-mês, mês, dia-da-semana).

- Exemplo para execução diária às 2 da manhã: 0 2 * * *

- Para verificar os registros de agendamento, o arquivo 'procore_scheduling.log' será criado assim que o agendamento for configurado.

Você também pode verificar o agendamento executando o comando no terminal:

Para Linux e MacOs:

Para editar/excluir - edite o cron de agendamento usando:

''Bash

EDITOR=nano crontab -e

```

- Depois de executar o comando acima, você verá algo semelhante a:

- 2 * * * * /Users/your_user/snowflake/venv/bin/python /Users/your_user/snowflake/sql_server_python/connection_config.py 2>&1 | durante a linha de leitura; fazer echo "$(date) - $line"; feito >> /Users/your_user/snowflake/sql_server_python/procore_scheduling.log #procore-data-import

- Você também pode ajustar o cron do cronograma ou excluir toda a linha para interrompê-lo em execução por agendamento.

Para Windows:

- Verifique se a tarefa do cronograma foi criada:

'''powershell

schtasks /query /tn "ProcoreDeltaShareScheduling" /fo LIST /v

``` - Para editar/excluir - agendando tarefa:

Abra o Agendador de Tarefas:- Pressione Win + R, digite taskschd.msc, e pressione Enter.

- Navegue até as tarefas agendadas.

- No painel esquerdo, expanda a Biblioteca do Agendador de Tarefas.

- Procure a pasta onde sua tarefa foi salva (por exemplo, Biblioteca do Agendador de Tarefas ou uma pasta personalizada).

- Encontre sua tarefa:

- Procure o nome da tarefa ProcoreDeltaShareScheduling.

- Clique nele para visualizar seus detalhes no painel inferior.

- Confira sua programação:

- Verifique a guia Gatilhos para ver quando a tarefa está definida para ser executada.

- Verifique a guia Histórico para confirmar as execuções recentes.

- Para excluir tarefa:

- Exclua a tarefa da GUI.

Questão de Execução Imediata:

- Opção para executar script para copiar dados imediatamente após a configuração.

- Depois de gerar o config.yaml, a CLI está pronta para ser executada a qualquer momento de forma independente, executando script para copiar dados, dependendo do seu pacote. Veja exemplos abaixo:

delta_share_to_azure_panda.py Python

OU

Python delta_share_to_sql_spark.py

OU

Python delta_share_to_azure_dfs_spark.py

Execução e Manutenção

Problemas e soluções comuns

- Configuração do trabalho Cron:

- Verifique se as permissões do sistema estão configuradas corretamente.

- Verifique os logs do sistema se o trabalho não for executado.

- Verifique se o script delta_share_to_azure_panda.py tem permissões de execução.

- Arquivo de configuração:

- Verifique se o arquivo config.yaml está no mesmo diretório que o script.

- Faça backup do arquivo antes de fazer alterações.

Suporte

Para obter ajuda adicional:

- Revise os logs de script para obter mensagens de erro detalhadas.

- Verifique se há configurações incorretas no arquivo config.yaml .

- Entre em contato com o administrador do sistema para problemas relacionados à permissão.

- Entre em contato com suporte do Procore para problemas relacionados ao acesso ao Delta Share.

- Revise o log de tabelas com falha: failed_tables.log.

Obs.

- Sempre faça backup de seus arquivos de configuração antes de fazer alterações.

- Teste novas configurações em um ambiente que não seja de produção para evitar interrupções.

Conectar-se ao ADLS usando o Spark

Visão geral

Este guia fornece instruções detalhadas para configurar e usar o pacote de integração do Compartilhamento Delta em um sistema operacional Windows para integrar dados perfeitamente em seus fluxos de trabalho com Procore Analytics. O pacote suporta várias opções de execução, permitindo que você escolha a configuração e o método de integração desejados.

Pré-requisitos

Certifique-se de ter o seguinte antes de prosseguir:

- Procore Analytics 2.0 SKU

- Arquivo pofile de compartilhamento delta:

Obtenha seu arquivo *.share contendo o Delta Sharing credenciais. Por conveniência, copie-o para o diretório do pacote. - Ambiente Python: Instale o Python 3 e o pip em seu sistema.

- Faça o download do Python.

- Como alternativa, use a Microsoft Store.

Passos

- Preparar o Pacote

- Instalar dependências

- Gerar configuração

- Configurar Cron Jobs e Execução Imediata

- Execução e Manutenção

Preparar o Pacote

- Crie um novo arquivo chamado config.share com seu Delta Share credenciais no formato JSON.

{

"shareCredentialsVersion": 1,

"bearerToken": "xxxxxxxxxxxxx",

"ponto de extremidade": "https://nvirginia.nuvem. databricks.c... alojas/xxxxxx"

}

- Obtenha os campos obrigatórios.

Nota: Esses detalhes podem ser obtidos no aplicativo Web Procore Analytics.- ShareCredentialsVersion: Número da versão (atualmente 1).

- BearerToken: Seu token de acesso Delta Share.

- Ponto de extremidade: seu endpoint de compartilhamento Delta URL.

- Baixe e extraia o pacote.

- Descompacte o pacote em um diretório de sua escolha.

- Copie o arquivo de perfil *.share Delta Sharing para o diretório do pacote para facilitar o acesso.

Instalar dependências

- Abra um terminal no diretório do pacote.

- Execute o seguinte comando para instalar as dependências:

- pip install -r requirements.txt

Gerar configuração

- Gere o arquivo config.yaml executando python user_exp.py:

Esse script ajuda a gerar o arquivo config.yaml que contém credenciais e configurações necessárias. - Ao configurar a fonte de dados, você será solicitado a fornecer:

- Lista de tabelas (separadas por vírgula).

- Deixe em branco para sincronizar todas as tabelas.

Exemplo: 'tabela1, tabela2, tabela3'. - Caminho para o seu 'config.share' arquivo.

- Pela primeira vez, você fornecerá seus credenciais como local de configuração de origem do Delta Share, tabelas, banco de dados, host e etc.

Nota: Depois, você pode reutilizar ou atualizar a configuração manualmente ou pelo user_exp.py python em execução novamente.

Configurar trabalhos cron e execução imediata (opcional)

- Decida se deseja configurar um trabalho cron para execução automática.

- Forneça um cronograma cron:

- Formato: * * * * * ( minuto, hora, dia-do-mês, mês, dia-da-semana).

- Exemplo para execução diária às 2 da manhã: 0 2 * * *

- Para verificar os registros de agendamento, o arquivo 'procore_scheduling.log' será criado assim que o agendamento for configurado.

Você também pode verificar o agendamento executando o comando no terminal:

Para Linux e MacOs:

Para editar/excluir - edite o cron de agendamento usando:

''Bash

EDITOR=nano crontab -e

```

- Depois de executar o comando acima, você verá algo semelhante a:

- 2 * * * * /Users/your_user/snowflake/venv/bin/python /Users/your_user/snowflake/sql_server_python/connection_config.py 2>&1 | durante a linha de leitura; fazer echo "$(date) - $line"; feito >> /Users/your_user/snowflake/sql_server_python/procore_scheduling.log #procore-data-import

- Você também pode ajustar o cron do cronograma ou excluir toda a linha para interrompê-lo em execução por agendamento.

Para Windows:

- Verifique se a tarefa do cronograma foi criada:

'''powershell

schtasks /query /tn "ProcoreDeltaShareScheduling" /fo LIST /v

``` - Para editar/excluir - agendando tarefa:

Abra o Agendador de Tarefas:- Pressione Win + R, digite taskschd.msc, e pressione Enter.

- Navegue até as tarefas agendadas.

- No painel esquerdo, expanda a Biblioteca do Agendador de Tarefas.

- Procure a pasta onde sua tarefa foi salva (por exemplo, Biblioteca do Agendador de Tarefas ou uma pasta personalizada).

- Encontre sua tarefa:

- Procure o nome da tarefa ProcoreDeltaShareScheduling.

- Clique nele para visualizar seus detalhes no painel inferior.

- Confira sua programação:

- Verifique a guia Gatilhos para ver quando a tarefa está definida para ser executada.

- Verifique a guia Histórico para confirmar as execuções recentes.

- Para excluir tarefa:

- Exclua a tarefa da GUI.

Questão de Execução Imediata:

- Opção para executar script para copiar dados imediatamente após a configuração.

- Depois de gerar o config.yaml, a CLI está pronta para ser executada a qualquer momento de forma independente, executando script para copiar dados, dependendo do seu pacote. Veja exemplos abaixo:

delta_share_to_azure_panda.py Python

OU

Python delta_share_to_sql_spark.py

OU

Python delta_share_to_azure_dfs_spark.py

Execução e Manutenção

Problemas e soluções comuns

- Configuração do trabalho Cron:

- Verifique se as permissões do sistema estão configuradas corretamente.

- Verifique os logs do sistema se o trabalho não for executado.

- Verifique se o script delta_share_to_azure_panda.py tem permissões de execução.

- Arquivo de configuração:

- Verifique se o arquivo config.yaml está no mesmo diretório que o script.

- Faça backup do arquivo antes de fazer alterações.

Suporte

Para obter ajuda adicional:

- Revise os logs de script para obter mensagens de erro detalhadas.

- Verifique se há configurações incorretas no arquivo config.yaml .

- Entre em contato com o administrador do sistema para problemas relacionados à permissão.

- Entre em contato com o suporte do Procore para problemas relacionados ao acesso ao Delta Share.

- Revise o log de tabelas com falha: failed_tables.log.

Obs.

- Sempre faça backup de seus arquivos de configuração antes de fazer alterações.

- Teste novas configurações em um ambiente que não seja de produção para evitar interrupções.

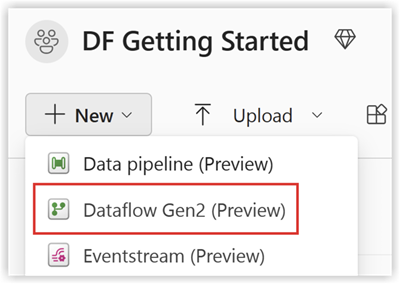

Conectar-se ao Fabric Lakehouse usando o Data Factory

Visão geral

A integração do Compartilhamento Delta com o Microsoft Fabric Data Factory permite o acesso e o processamento contínuos de tabelas Delta compartilhadas para seus fluxos de trabalho de análise com o Procore Analytics 2.0. O Delta Sharing, um protocolo aberto para colaboração segura de dados, garante que as organizações possam compartilhar dados sem duplicação.

Pré-requisitos

- Procore Analytics 2.0 SKU

- Credenciais de compartilhamento Delta:

- Obtenha o arquivo share.json (ou equivalente) Delta Sharing credenciais do seu provedor de dados.

- Esse arquivo deve incluir:

- Ponto de extremidade URL: O Delta Sharing Server URL.

- Token ao portador: Usado para acesso seguro a dados.

- Instalação do Microsoft Fabric:

- Uma conta de locatário do Microsoft Fabric com uma assinatura ativa.

- Acesso a um espaço de trabalho habilitado para Microsoft Fabric.

Passos

- Alternar para a experiência do Data Factory

- Configurar o fluxo de dados

- Realizar transformações de dados

- Validação e Monitoramento

Alternar para a experiência do Data Factory

- Navegue até o Espaço de Trabalho do Microsoft Fabric.

- Selecione Novo e, em seguida, escolha Dataflow Gen2.

Configurar o fluxo de dados

- Vá para o editor de fluxo de dados.

- Clique em Obter dados e selecione Mais.

- Em Nova fonte, selecione Delta Sharing Other como a fonte de dados.

- Insira os seguintes detalhes:

- URL: Do arquivo de configuração do Compartilhamento Delta.

- Token ao portador: encontrado no arquivo config.share.

- Clique em Avançar e selecione as tabelas desejadas.

- Clique em Criar para concluir o configuração.

Realizar transformações de dados

Depois de configurar o fluxo de dados, agora você pode aplicar transformações aos dados Delta compartilhados. Escolha sua opção Delta Sharing Data na lista abaixo:

- Adicionar destino de dados

- Criar/Abrir Lakehouse

Adicionar destino de dados

- Vá para Data Factory.

- Clique em Adicionar destino de dados.

- Selecione Lakehouse como destino e clique em Avançar.

- Escolha seu destino e confirme clicando em Avançar.

Criar-Open Lakehouse

- Crie/abra sua Lakehouse e clique em Obter dados.

- Selecione Novo Dataflow Gen2.

- Clique em Obter Dados, depois em Mais e localize Compartilhamento Delta.

- Insira o token de portador de URL do arquivo config.share e selecione Next.

- Escolha seus dados/tabela/s para baixar e clique em Avançar.

- Após essas manipulações, você deve ter todos os dados selecionados em seu Fabric Lakehouse.

Validação e Monitoramento

Teste seus pipelines e fluxos de dados para garantir uma execução suave. Usar ferramentas de monitoramento nos dados

Fábrica para acompanhar o progresso e os registros de cada atividade.

Conecte-se ao Fabric Lakehouse usando blocos de anotações de tecido

Visão geral

O uso do Data Factory no Microsoft Fabric com o Compartilhamento Delta permite a integração e o processamento contínuos de tabelas Delta compartilhadas como parte de seus fluxos de trabalho de análise com o Procore Analytics 2.0. O Compartilhamento Delta é um protocolo aberto para compartilhamento seguro de dados, permitindo a colaboração entre organizações sem duplicar dados.

Este guia orienta você pelas etapas para configurar e usar o Data Factory em malha com o Compartilhamento Delta, utilizando Notebooks para processar e exportar dados para uma Lakehouse.

Pré-requisitos

- Procore Analytics 2.0 SKU

- Credenciais de compartilhamento Delta:

- O acesso ao Delta Sharing credenciais fornecido por um provedor de dados.

- Um arquivo de perfil de compartilhamento (config.share) Contendo:

- Ponto de extremidade URL (Delta Sharing Server URL ).

- Access Token (Token ao portador para acesso seguro a dados).

- Crie seu arquivo config.yaml com credenciais específicos.

- Ambiente do Microsoft Fabric:

- Uma conta de locatário do Microsoft Fabric com uma assinatura ativa.

- Um espaço de trabalho habilitado para malha.

- Pacotes e Scripts:

- Faça o download do pacote fabric-lakehouse. O diretório deve incluir:

- ds_to_lakehouse.py: Código do bloco de anotações.

- readme.md: Instruções.

- Faça o download do pacote fabric-lakehouse. O diretório deve incluir:

Passos

Definir configuração

- Crie o config.yaml e defina a configuração na seguinte estrutura

source_config:

config_path: caminho/para/seu/delta-sharing-credentials-file.share

tabelas: # Opcional - Deixar em branco para processar todas as tabelas

- table_name1

- table_name2

target_config:

lakehouse_path: caminho/para/seu/tecido/lakehouse/Mesas/ # Caminho para o Fabric Lakehouse

Configure sua Lakehouse

- Abra seu espaço de trabalho do Microsoft Fabric.

- Navegue até o Lakehouse e clique em Abrir Bloco de Anotações e, em seguida, em Novo Bloco de Anotações.

- Se você não souber o valor em config.yaml#lakehouse_path, você pode copiá-lo da tela.

- Clique nas reticências em Arquivos e selecione Copiar caminho ABFS:

3. Copie o código do ds_to_lakehouse.py e cole na janela do notebook (Pyspark Python):

A próxima etapa é carregar seu próprio config.yaml e config.share na pasta Recursos do Lakehouse. Você pode criar seu próprio diretório ou usar um diretório interno (já criado para recursos pela Lakehouse):

O exemplo abaixo mostra um diretório interno padrão para um arquivo config.yaml.

Nota: Certifique-se de carregar ambos os arquivos no mesmo nível e para a propriedade config_path:

4. Verifique o código do caderno, linhas 170-175.

O exemplo abaixo mostra as alterações de linha necessárias:

config_path = "./env/config.yaml"

Para

config_path = "./builtin/config.yaml"

Como os arquivos estão em uma pasta interna e não em um env personalizado, certifique-se de monitorar sua própria estrutura dos arquivos. Você pode carregá-los em pastas diferentes, mas nesses casos, atualize o código do bloco de anotações para encontrar o arquivo config.yaml corretamente.

5. Clique em Executar célula:

Validação

- Quando o trabalho for concluído, verifique se os dados foram copiados com sucesso para o seu Lakehouse.

- Verifique as tabelas especificadas e verifique se os dados correspondem às tabelas Delta compartilhadas.

- Aguarde até que o trabalho seja concluído, ele deve copiar todos os dados.

Conectar-se ao SQL Server usando o Azure Functions

Visão geral

Este guia orienta você na configuração e implantação de uma Função do Azure para integrar dados de Compartilhamento Delta com Procore Analytics. A Função do Azure permite fluxos de trabalho eficientes de processamento e compartilhamento de dados com perfis de Compartilhamento Delta.

Pré-requisitos

- Procore Analytics SKU 2.0.

- Arquivo de perfil de compartilhamento Delta:

- Seu arquivo *.share contendo o Delta Sharing credenciais. Por conveniência, coloque-o dentro do pacote baixado.

- Ambiente Python:

- Instalado Python 3.9+ e pip em seu sistema.

- Instalação do Azure:

- CLI do Azure instalada e conectada.

- O Azure Functions ferramentas principais instalado.

Passos

- Prepare the Package

- Install Dependencies

- Generate Configuration

- Azure CLI Setup

- Install Azure Functions Core Tools

- Prepare the Azure Function

- Deployment

- Validation

Preparar o Pacote

- Faça o download do pacote necessário (adls_azure_function ou sql_server_azure_function).

- Extraia os arquivos de pacote para um diretório local.

- Coloque o arquivo de compartilhamento Delta:

- Copie seu arquivo de perfil *.share Delta Sharing para o diretório extraído.

Instalar dependências

- Abra um terminal no diretório do pacote.

- Execute o seguinte comando para instalar as dependências necessárias do Python:

- pip install -r requirements.txt

Gerar configuração

- Gere o arquivo config.yaml executando:

- user_exp.py Python

- O script solicitará que você insira credenciais como:

- Tabelas

- Nome do banco de dados

- Anfitrião

- credenciais adicionais.

- A configuração pode ser reutilizada ou atualizada manualmente ou executando novamente o user_exp.py python.

Configuração da CLI do Azure

- Faça logon no Azure.

- Execute o seguinte comando para fazer login:

az login - Verifique a conta do Azure:

- az account show

- Se o comando az não estiver disponível, instale a CLI do Azure seguindo as instruções encontradas aqui: Microsoft Learn.

Instalar o Azure Functions ferramentas principais

Ir para

para obter instruções sobre como instalar o Azure Functions ferramentas principais.Preparar a função do Azure

- Use o botãoPara criar o seguinte:

- Um aplicativo de função

- Um grupo de recursos

- Plano de consumo

- Conta de armazenamento

- Definir agendamento Cron personalizado (opcional).

- Abra function_app.py em um editor.

- Localize a linha: @app.timer_trigger(schedule="0 0 */8 * * *",

- Substitua o agendamento por sua expressão Cron personalizada e salve o arquivo.

Implantação

- Abra um terminal no diretório de pacotes (adls_azure_function).

- Execute o seguinte comando de implantação:

- func azure functionapp publish <FunctionAppName> --build remote --python --clean

- Substitua<FunctionAppName> pelo nome do seu aplicativo de função do Azure em sua assinatura do Azure.

Validação

- Certifique-se de que a implantação seja bem-sucedida verificando o status do aplicativo de função no Portal do Azure.

- Monitore os logs para verificar se a função está sendo executada conforme o esperado.

Conectar-se ao SQL Server usando o Data Factory

Visão geral

Este documento fornece instruções passo a passo para configurar um pipeline de dados no Microsoft Fabric para transferir dados do Compartilhamento Delta para um armazém SQL. Essa configuração permite a integração perfeita de dados entre as origens do Delta Lake e os destinos SQL.

Pré-requisitos

- Conta ativa do Microsoft Fabric com as permissões adequadas.

- Delta Share credenciais.

- SQL warehouse credenciais.

- Acesso ao Data Flow Gen2 em malha.

Passos

- Acessar o fluxo de dados Gen2

- Configurar dados Fonte

- Configurar a conexão de compartilhamento delta

- Configurar destino de dados

- Finalizar e implantar

- Verificação

- Solucionando problemas

Acessar o fluxo de dados Gen2

- Faça logon na sua conta do Microsoft Fabric.

- Navegue até a área de trabalho.

- Selecione 'Data Flow Gen2' nas opções disponíveis.

Configurar fonte de dados

- Clique em 'Dados de outra fonte' para iniciar a configuração.

- Na tela Obter dados, faça o seguinte:

- Localize a barra de pesquisa rotulada como "Escolher fonte de dados".

- Digite "compartilhamento delta" no campo de pesquisa.

- Selecione Compartilhamento Delta nos resultados.

Configurar a conexão de compartilhamento delta

- Insira seu credenciais de compartilhamento Delta quando solicitado.

- Certifique-se de que todos os campos obrigatórios sejam preenchidos corretamente.

- Se possível, valide a conexão.

- Clique em "Avançar" para continuar.

- Revise a lista de tabelas disponíveis:

- Todas as tabelas às quais você tem acesso serão exibidas.

- Selecione as tabelas desejadas para transferência.

Configurar destino de dados

- Clique em 'Adicionar destino de dados'.

- Selecione 'SQL warehouse' como seu destino.

- Digite SQL credenciais:

- Detalhes do servidor.

- Informações de autenticação.

- Especificações de banco de dados.

- Verifique as configurações de conexão.

Finalizar e implantar

- Revise todas as configurações.

- Clique em "Publicar" para implantar o fluxo de dados.

- Aguarde a mensagem de confirmação.

Verificação

- Acesse seu SQL warehouse.

- Verifique se os dados estão disponíveis e estruturados adequadamente.

- Execute consultas de teste para garantir a integridade dos dados.

Solucionando problemas

Problemas e soluções comuns:

- Falhas de conexão: verifique credenciais e conectividade de rede.

- Tabelas ausentes: verifique as permissões de compartilhamento Delta.

- Problemas de desempenho: revise as configurações de alocação e otimização de recursos.

Conectar-se ao SQL Server usando o Bloco de Anotações de Malha

Visão geral

O uso do Data Factory no Microsoft Fabric com o Compartilhamento Delta permite a integração e o processamento contínuos de tabelas Delta compartilhadas como parte de seus fluxos de trabalho de análise com o Procore Analytics 2.0. O Compartilhamento Delta é um protocolo aberto para compartilhamento seguro de dados, permitindo a colaboração entre organizações sem duplicar dados.

Este guia orienta você pelas etapas para configurar e usar o Data Factory em malha com o Compartilhamento Delta, utilizando Notebooks para processar e exportar dados para uma Lakehouse.

Pré-requisitos

- Procore Analytics 2.0 SKU

- Credenciais de compartilhamento Delta:

- O acesso ao Delta Sharing credenciais fornecido por um provedor de dados.

- Um arquivo de perfil de compartilhamento (config.share) Contendo:

- Ponto de extremidade URL (Delta Sharing Server URL ).

- Access Token (Token ao portador para acesso seguro a dados).

- Crie seu arquivo config.yaml com credenciais específicos.

- Ambiente do Microsoft Fabric:

- Uma conta de locatário do Microsoft Fabric com uma assinatura ativa.

- Um espaço de trabalho habilitado para malha.

- Pacotes e Scripts:

- Faça o download do pacote fabric-lakehouse. O diretório deve incluir:

- ds_to_lakehouse.py: Código do bloco de anotações.

- readme.md: Instruções.

- Faça o download do pacote fabric-lakehouse. O diretório deve incluir:

Passos

Definir configuração

- Crie o config.yaml e defina a configuração na seguinte estrutura

source_config:

config_path: caminho/para/seu/delta-sharing-credentials-file.share

tabelas: # Opcional - Deixar em branco para processar todas as tabelas

- table_name1

- table_name2

target_config:

lakehouse_path: caminho/para/seu/tecido/lakehouse/Mesas/ # Caminho para o Fabric Lakehouse

Configure sua Lakehouse

- Abra seu espaço de trabalho do Microsoft Fabric.

- Navegue até o Lakehouse e clique em Abrir Bloco de Anotações e, em seguida, em Novo Bloco de Anotações.

- Se você não souber o valor em config.yaml#lakehouse_path, você pode copiá-lo da tela.

- Clique nas reticências em Arquivos e selecione Copiar caminho ABFS:

3. Copie o código do ds_to_lakehouse.py e cole na janela do notebook (Pyspark Python):

A próxima etapa é carregar seu próprio config.yaml e config.share na pasta Recursos do Lakehouse. Você pode criar seu próprio diretório ou usar um diretório interno (já criado para recursos pela Lakehouse):

O exemplo abaixo mostra um diretório interno padrão para um arquivo config.yaml.

Nota: Certifique-se de carregar ambos os arquivos no mesmo nível e para a propriedade config_path:

4. Verifique o código do caderno, linhas 170-175.

O exemplo abaixo mostra as alterações de linha necessárias:

config_path = "./env/config.yaml"

Para

config_path = "./builtin/config.yaml"

Como os arquivos estão em uma pasta interna e não em um env personalizado, certifique-se de monitorar sua própria estrutura dos arquivos. Você pode carregá-los em pastas diferentes, mas nesses casos, atualize o código do bloco de anotações para encontrar o arquivo config.yaml corretamente.

5. Clique em Executar célula:

Validação

- Quando o trabalho for concluído, verifique se os dados foram copiados com sucesso para o seu Lakehouse.

- Verifique as tabelas especificadas e verifique se os dados correspondem às tabelas Delta compartilhadas.

- Aguarde até que o trabalho seja concluído, ele deve copiar todos os dados.

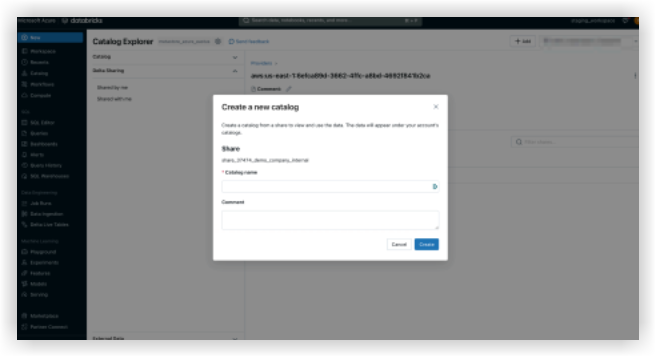

Conectar-se a databricks

Obs.

Esse método de conexão é normalmente usado por profissionais de dados.- Faça login em seu ambiente de Databricks.

- Navegue até a seção Catálogo .

- Selecione Compartilhamento Delta no menu superior.

- Selecione Compartilhado comigo.

- Copie o Identificador de Compartilhamento fornecido para você.

- Compartilhe o Identificador de Compartilhamento com a equipe suporte do Procore.

Nota: Depois que o identificador de compartilhamento for adicionado ao sistema do Procore, a conexão do Procore Databricks aparecerá na guia Compartilhado comigo em Provedores em seu ambiente Databricks. Pode levar até 24 horas para ver os dados.

- Quando sua conexão do Procore Databricks ficar visível na guia Compartilhado comigo , selecione o Identificador do Procore e clique em Criar catálogo.

- Insira seu nome preferido para o catálogo compartilhado e clique em Criar.

- Seu catálogo e tabelas compartilhados agora serão exibidos sob o nome fornecido no Explorador de catálogos.

Entre em contato com o suporte do Procore se tiver alguma dúvida ou precisar de assistência.

Conectar-se ao Snowflake usando Python

Visão geral

A ferramenta Procore Analytics Cloud Connect Access é uma interface de linha de comando (CLI) que ajuda você a configurar e gerenciar transferências de dados do Procore para o Snowflake.

Consiste em dois componentes principais:

- user_exp.py: Utilitário configuração configuração

- ds_to_snowflake.py: Script de sincronização de dados

Pré-requisitos

- Python está instalado no seu sistema

- Acesso ao compartilhamento Delta do Procore

- Conta Flocos de neve credenciais

- Instale as dependências necessárias usando:

- pip install -r requirements.txt

Passos

- Configuração Inicial

- Sincronização de dados

- Configuração de origem do compartilhamento delta

- Configuração do destino do floco de neve

- Opções de agendamento

- Práticas recomendadas

- Solucionando problemas

Configuração Inicial

Execute o utilitário de configuração usando python user_exp.py.

Sincronização de dados

Após a configuração, você tem duas opções para executar a sincronização de dados:

- Execução Direta:

- ds_to_snowflake.py Python

- Execução Programada

- Se configurado durante configuração, o trabalho será executado automaticamente de acordo com sua programação Cron.

- Para verificar os registros de agendamento, o arquivo 'procore_scheduling.log' será criado assim que o agendamento for configurado.

- Além disso, você pode verificar o agendamento executando o comando terminal:

Para Linux e MacOS:

- Para editar/excluir - edite o cron de agendamento usando:

''Bash

EDITOR=nano crontab -e

``` - Depois de executar o comando acima, você verá algo semelhante a:

2 * * * *

/Usuários/your_user/floco de neve/venv/bin/python

/Usuários/your_user/Flocos de neve/sql_server_python/connection_config.py

2>&1 | durante a linha de leitura; fazer echo "$(date) - $line"; feito>>

/Usuários/your_user/floco de neve/sql_server_python/procore_scheduling.log #procore-data-import - Você também pode ajustar o cron do cronograma ou excluir toda a linha para interrompê-lo em execução por agendamento.

Para Windows:

- Verifique se a tarefa do cronograma foi criada:

```

powershell

schtasks /query /tn "ProcoreDeltaShareScheduling" /fo LIST /v

```

- Para editar/excluir tarefa de agendamento, abra o Agendador de Tarefas.

- Pressione Win + R, digite taskschd.msc, e pressione enter.

- Navegue até as tarefas agendadas.

- No painel esquerdo, expanda a Biblioteca do Agendador de Tarefas.

- Procure a pasta onde sua tarefa foi salva:

Exemplo: Biblioteca do Agendador de Tarefas ou uma pasta personalizada. - Encontre sua tarefa.

- Procure o nome da tarefa: ProcoreDeltaShareScheduling.

- Clique nele para visualizar os detalhes no painel inferior.

- Confira sua programação:

- Verifique a guia Gatilhos para ver quando a tarefa está definida para ser executada.

- Verifique a guia Histórico para confirmar as execuções recentes.

- Para excluir tarefa:

- Exclua a tarefa da GUI.

Configuração de compartilhamento delta

- Criando o arquivo config.share

- Antes de executar o utilitário de configuração, você precisa criar um arquivo config.share com seu Delta Share credenciais. O arquivo deve estar no formato JSON:

{

"shareCredentialsVersion": 1,

"bearerToken": "xxxxxxxxxxxxx",

"ponto de extremidade": "https://nvirginia.nuvem. databricks.c... alojas/xxxxxx"

}

- Campos obrigatórios:

- ShareCredentialsVersion: Número da versão (atualmente 1).

- BearerToken: Seu token de acesso Delta Share.

- Ponto de extremidade: seu endpoint de compartilhamento Delta URL.

- Esses detalhes podem ser obtidos na interface do usuário da Web do Procore.

- Etapas para criar config.share:

- Crie um novo arquivo chamado config.share.

- Copie o modelo JSON acima.

- Substitua os valores de espaço reservado pelo seu credenciais real.

- Salve o arquivo em um local seguro.

- Você precisará fornecer o caminho para esse arquivo durante a configuração. Ao configurar a fonte de dados, você será solicitado a fornecer:

- Lista de tabelas (separadas por vírgula).

- Deixe em branco para sincronizar todas as tabelas.

- Exemplo: tabela1, tabela2, tabela3.

- Caminho para o arquivo config.share .

Configuração do Flocos de Neve

Você precisará fornecer os seguintes detalhes do Flocos de Neve:

- Autenticação (escolha uma):

- Autenticação do usuário

- Nome de usuário

- Senha (digitada com segurança)

- Autenticação do usuário

- Autenticação de par de chaves

- Nome de usuário

- Caminho do arquivo de chave privada

- Senha do arquivo de chave privada

- Detalhes da conexão:

- Identificador da conta

- Nome do armazém

- Nome do banco de dados

- Nome do esquema

- Número de threads simultâneos

Opções de agendamento

A ferramenta oferece a capacidade de agendar a sincronização automática de dados.

- Configuração do trabalho Cron

- Escolher se deseja configurar um trabalho diário

- Se sim, forneça um cronograma cron

- Formato: * * * * * (minuto hora dia-do-mês mês, dia-da-semana)

- Exemplo para diariamente às 2 da manhã: 0 2 * * *

- Execução Imediata

- Opção para executar o ds_to_snowflake.py imediatamente após a configuração

- Estrutura de arquivos

Unset

├── requirements.txt # Dependências

├── user_exp.py # Utilitário de configuração

├── ds_to_snowflake.py # Script de sincronização de dados

├── config.yaml # Configuração gerada

├── config.share # Arquivo de configuração do Delta Share

├── procore_scheduling.log # Log de execuções de agendamento

Exemplo de uso- Etapa 1: Instalar dependências

$ pip instalar -r requirements.txt - Etapa 2: Executar o utilitário de configuração

$ python user_exp.py - Acesso ao Procore Analytics Cloud Connect

- Essa CLI ajudará você a escolher seu armazenamento de origem e destino para acessar/gravar dados do Procore no Snowflake.

- Pressione Enter para continuar.

- Insira a lista de tabelas (separadas por vírgula), deixe-a em branco para todas as tabelas: projetos,usuários,tarefas.

- Digite o caminho para config.share: /caminho/para/config.share.

- Digite o nome de usuário: snowflake_user.

- Qual tipo de autenticação você deseja usar? (usuário/key_pair): Digite.

- 1 para o usuário,

- 2 para o par de chaves:

- 1

- Digite a senha: ********

- Digite a conta: my_account

- Entre no armazém: my_warehouse

- Digite o nome do banco de dados: procore_db

- Digite o nome do esquema: procore_schema

- Digite o número de tópicos: 4

- Você quer configurar isso como um trabalho diário no cron? (Sim/Não): Sim

- Insira o cronograma no formato cron (por exemplo, * * * * * ): 0 2 * * *

- Quer executar o trabalho agora? (Sim/Não): Sim

- Etapa 3: Execução manual (se necessário)

$ python ds_to_snowflake.py

- Etapa 1: Instalar dependências

- Reutilização de configuração

A ferramenta salva sua configuração no arquivo config.yaml e oferece a reutilização de configurações armazenadas anteriormente:- A configuração de origem pode ser reutilizada.

- A configuração de destino (floco de neve) pode ser reutilizada.

- Você pode optar por atualizar qualquer configuração independentemente.

Práticas recomendadas

- Autenticação

- Use a autenticação de par de chaves quando possível.

- Gire regularmente credenciais.

- Use as permissões mínimas necessárias.

- Desempenho

- Ajuste a contagem de threads com base nos recursos do sistema.

- Comece com um subconjunto menor de tabelas para teste.

Solucionando problemas

- Problemas e soluções comuns:

- Tipo de autenticação inválido

- Certifique-se de selecionar '1' (usuário) ou '2' (key_pair) quando solicitado.

- Tipo de autenticação inválido

- Configuração do trabalho Cron

- Verifique se você tem as permissões de sistema adequadas.

- Verifique os logs do sistema se o trabalho não for executado.

- Verifique se o ds_to_snowflake.py tem permissões corretas.

- Verifique o configuração do trabalho cron verificando os logs do sistema:

Consulte o arquivo "procore_scheduling.log ".

- Arquivo de configuração

- Localizado no mesmo diretório que o script,

- Chamado config.yaml.

- Faça backup antes de fazer qualquer alteração.

- Suporte

- Verifique a saída de log do script.

- Revise seu arquivo config.yaml .

- Entre em contato com o administrador do sistema para problemas relacionados à permissão.

- Entre em contato com suporte do Procore para problemas de acesso ao Delta Share.

Nota: Lembre-se de sempre fazer backup de sua configuração antes de fazer alterações e testar novas configurações em um ambiente que não seja de produção primeiro.

Conectar-se ao Amazon S3 usando Python

Visão geral

A ferramenta Procore Analytics Cloud Connect Access é uma interface de linha de comando (CLI) que ajuda a configurar e gerenciar transferências de dados do Procore para o Amazon S3 com Procore Analytics 2.0.

Consiste em dois componentes principais:

- user_exp.py: Utilitário configuração configuração

- delta_share_to_s3.py: Script de sincronização de dados

Pré-requisitos

- Procore Analytics 2.0 SKU

- Python está instalado no seu sistema

- Acesso ao compartilhamento Delta do Procore

- Teclas de acesso do S3

- Instalação das dependências necessárias utilizando:

- pip install -r requirements.txt

Passos

- Configuração Inicial

- Configuração de origem do compartilhamento delta

- Configuração do S3

- Opções de agendamento

- Práticas recomendadas

- Solucionando problemas

Configuração Inicial

Execute o utilitário de configuração usando python user_exp.py.

Isso ajudará você a configurar o seguinte:

- Configuração de compartilhamento delta

- Configuração de destino do S3

- Preferências de Agendamento

Configuração de compartilhamento delta

- Criando o arquivo config.share

- Antes de executar o utilitário de configuração, você precisa criar um arquivo config.share com seu Delta Share credenciais. O arquivo deve estar no formato JSON:

{

"shareCredentialsVersion": 1,

"bearerToken": "xxxxxxxxxxxxx",

"Ponto de extremidade": "xxxxxx"

}

- Campos obrigatórios:

- ShareCredentialsVersion: Número da versão (atualmente 1).

- BearerToken: Seu token de acesso Delta Share.

- Ponto de extremidade: seu endpoint de compartilhamento Delta URL.

- Esses detalhes podem ser obtidos na interface do usuário da Web do Procore.

- Etapas para criar config.share:

- Crie um novo arquivo chamado config.share.

- Copie o modelo JSON acima.

- Substitua os valores de espaço reservado pelo seu credenciais real.

- Salve o arquivo em um local seguro.

- Você precisará fornecer o caminho para esse arquivo durante a configuração. Ao configurar a fonte de dados, você será solicitado a fornecer:

- Lista de tabelas (separadas por vírgula).

- Deixe em branco para sincronizar todas as tabelas.

- Exemplo: tabela1, tabela2, tabela3.

- Caminho para o arquivo config.share .

Configuração do S3

Você precisará fornecer os seguintes detalhes do S3:

- Autenticação:

- Chave de acesso

- Chave Secreta

- Nome do bucket sem s3://

- Key - Diretório

Opções de agendamento

A ferramenta oferece a capacidade de agendar a sincronização automática de dados.

- Configuração do trabalho Cron

- Escolha se deseja configurar um trabalho diário.

- Se sim, forneça um cronograma cron.

- Formato: * * * * * (minuto hora dia-do-mês mês, dia-da-semana).

- Exemplo para diariamente às 2 da manhã: 0 2 * * *

- Para verificar os registros de agendamento, o arquivo 'procore_scheduling.log' será criado assim que o agendamento for configurado.

Você também pode verificar o agendamento executando o comando do terminal

Para Linux e MacOs:

Para editar/excluir - edite o cron de agendamento usando:

''Bash

EDITOR=nano crontab -e

```

- Depois de executar o comando acima, você verá algo semelhante a:

- 2 * * * * /Users/your_user/snowflake/venv/bin/python /Users/your_user/snowflake/sql_server_python/connection_config.py 2>&1 | durante a linha de leitura; fazer echo "$(date) - $line"; feito >> /Users/your_user/snowflake/sql_server_python/procore_scheduling.log #procore-data-import

- Você também pode ajustar o cron do cronograma ou excluir toda a linha para interrompê-lo em execução por agendamento.

Para Windows:

- Verifique se a tarefa do cronograma foi criada:

'''powershell

schtasks /query /tn "ProcoreDeltaShareScheduling" /fo LIST /v

``` - Para editar/excluir - agendando tarefa:

Abra o Agendador de Tarefas:- Pressione Win + R, digite taskschd.msc, e pressione Enter.

- Navegue até as tarefas agendadas.

- No painel esquerdo, expanda a Biblioteca do Agendador de Tarefas.

- Procure a pasta onde sua tarefa foi salva (por exemplo, Biblioteca do Agendador de Tarefas ou uma pasta personalizada).

- Encontre sua tarefa:

- Procure o nome da tarefa ProcoreDeltaShareScheduling.

- Clique nele para visualizar seus detalhes no painel inferior.

- Confira sua programação:

- Verifique a guia Gatilhos para ver quando a tarefa está definida para ser executada.

- Verifique a guia Histórico para confirmar as execuções recentes.

- Para excluir tarefa:

- Exclua a tarefa da GUI.

- Execução Imediata

- Opção para executar o delta_share_to_s3_.py Estrutura de arquivos

-

Unset

├── requirements.txt # Dependências

├── user_exp.py # Utilitário de configuração

├── delta_share_to_s3.py # Script de sincronização de dados

├── config.yaml # Configuração gerada

├── config.share # Arquivo de configuração do Delta Share

├── procore_scheduling.log # Log de execuções de agendamento

Exemplo de uso- Etapa 1: Instalar dependências

$ pip instalar -r requirements.txt - Etapa 2: Executar o utilitário de configuração

$ python user_exp.py - Acesso ao Procore Analytics Cloud Connect

- Essa CLI ajudará você a escolher seu armazenamento de origem e de destino para acessar/gravar dados do Procore no S3.

- Pressione Enter para continuar.

- Insira a lista de tabelas (separadas por vírgula), deixe-a em branco para todas as tabelas: projetos,usuários,tarefas.

- Digite o caminho para config.share: /caminho/para/config.share.